苹果Vision Pro眼动追踪系统相关新专利曝光,可与其他设备搭配进行远程眼动追踪

早在2017 年,苹果公司收购了一家名为 SensoMotoric Instruments(SMI)的德国公司,后者在眼动追踪技术领域拥有过硬的技术。2016 年,SMI 已经制造出了使用眼动追踪技术的眼镜。虽然这项技术在当时看来有些科幻,但现在它已经成为苹果即将推出的 Vision Pro 头显背后的关键技术之一。今天,美国专利商标局正式向苹果公司授予了一项与眼动追踪技术有关的专利,而在被列为发明人的4位工程师中,有3位就来自现就职于苹果公司的前 SMI 团队。

传感器融合眼动追踪

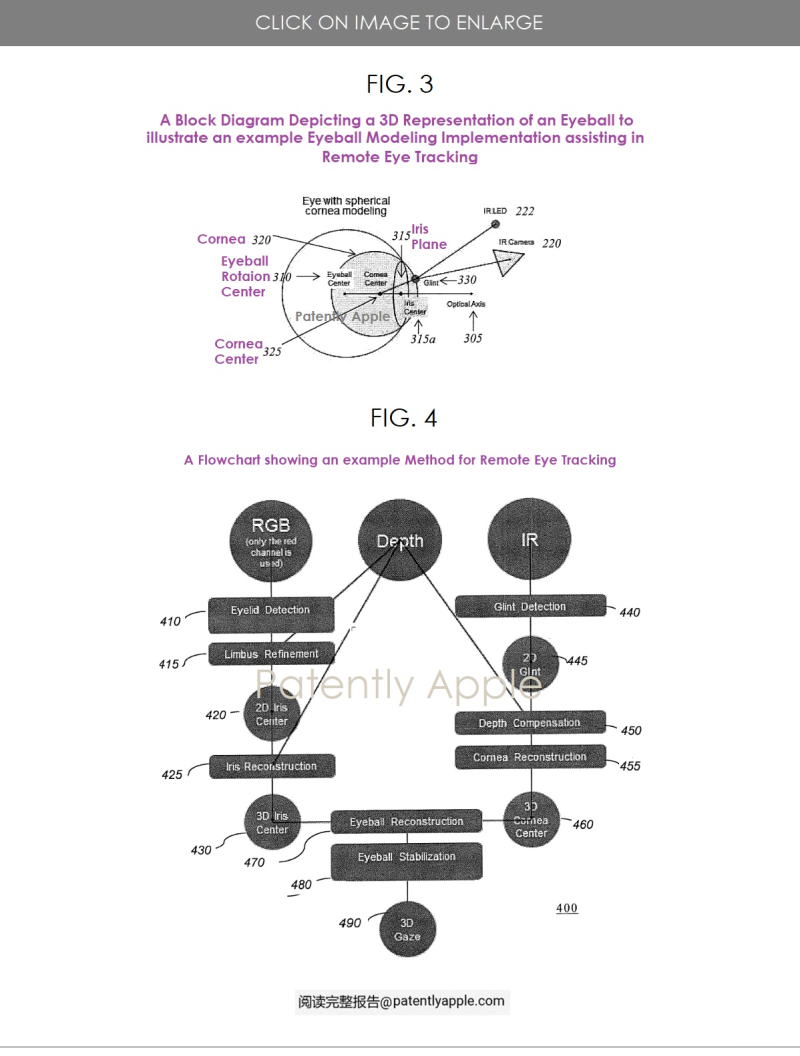

苹果公司获得的专利涵盖了各种实施方案,其中包括为相对于用户移动的电子设备执行远程眼动追踪的设备、系统和方法。

在某些实施方案中,远程眼动追踪通过使用单个有源照明光源和深度信息识别三维坐标系中沿注视方向的两个位置(例如角膜中心和眼球旋转中心)来确定注视方向。在某些实施方案中,使用基于主动照明光源的闪烁和深度传感器的深度信息确定第一位置(如角膜中心),使用 RGB 传感器(如环境光)和深度信息确定第二位置(如眼球旋转中心)。在某些实施方案中,使用相同主动照明光源的单个传感器确定第一位置(如角膜中心)和第二位置(如眼球旋转中心),单个传感器同时确定深度信息和闪光信息。在某些实施方案中,远程眼动追踪由移动电子设备提供。

在某些实施方案中,远程眼动追踪确定三维坐标系中的头部姿态以及眼球的位置(例如眼球旋转中心),然后确定头部姿态与眼球位置之间的空间关系。在某些实施方案中,空间关系是唯一确定的(例如,用户特定变换)。在某些实施方案中,空间关系是在远程眼动追踪的注册模式下确定的。随后,在远程眼动追踪的追踪模式的某些实现中,只有特征检测图像(例如 RGB 摄像头图像)和空间关系用于执行远程眼动追踪。在远程眼动追踪的追踪模式的某些实施方案中,深度信息和主动照明被关闭(例如,降低功耗)。

远程眼动追踪的一个用途是在用户注视的方向上识别设备上的视点(POR),例如,注视方向与设备显示屏相交的位置。视点可用于促进用户与设备的交互。例如,系统可以检测到用户的视线已经到达显示屏的底部,并自动向下滚动,向用户显示更多内容。

本专利一些实现涉及在具有一个或多个处理器、一个或多个图像传感器和照明光源的设备上,根据与眼睛第一图像中不同波长光相关的像素差异,检测眼睛的第一属性。这些实施方案根据深度传感器提供的深度信息,在三维坐标系中确定与第一属性相关的第一位置。各种实施方案根据照明光源的光线从眼睛角膜反射产生的闪光来检测眼睛的第二属性。这些实施方案根据来自深度传感器的深度信息,确定三维坐标系中与第二属性相关联的第二位置,并根据第一位置和第二位置确定三维坐标系中的注视方向。

各种实现方法根据在第二图像中检测到的头部(例如面部特征)和来自深度传感器的深度信息,确定三维坐标系中的头部位置。这些实施方案根据头部位置和先前确定的头部与眼睛之间的空间关系,确定与眼睛的第二属性相关联的第二位置,并根据第一位置和第二位置确定三维坐标系中的注视方向。