普林斯顿大学用AI神经网络从视频中对动物展开动作捕捉

你可能见过好莱坞明星身穿的动捕套装的样子,而计算机可以利用相应的传感器信息来将他们的表演转换成绿巨人或智慧猿人。

现在,普林斯顿教授Mala Murthy和Joshua Shaevitz的联手合作则更进一步,利用人工智能的最新进步来追踪动物的身体运动。

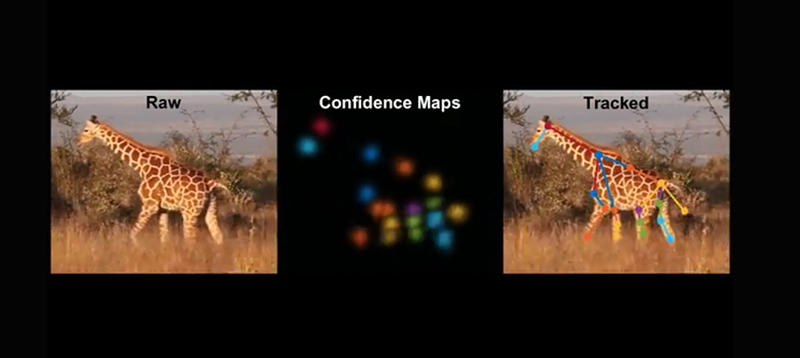

只需数分钟,他们研发的工具LEAP Estimates Animal Pose(LEAP)就能够以高精度自动追踪数百万帧视频中的各个动物身体部位,无需添加任何物理标记或标签。

详细介绍这项新技术的论文将发表在2019年1月出版的《Nature Methods》期刊上,但他们于5月推出的公开访问版本已经促使其他一系列的实验室采用了他们的软件。

相关论文:Fast animal pose estimation using deep neural networks

物理学教授Shaevitz指出,当研究人员将LEAP与其他定量工具相结合时,他们可以观察动物的运动模式,并研究所谓的“行为语言”。

普林斯顿神经科学研究所的研究生,论文第一作者Talmo Pereira说道:“这是一个灵活的工具,原则上可用于任何视频数据。具体的工作方式是,在几个视频中标记几个追踪点,然后神经网络即可完成剩下的工作。我们提供了一个易于使用的界面,任何人都可以将LEAP应用到自己的视频中,无需任何编程知识。”

当被问及LEAP在大型动物身上是否能实现跟苍蝇和老鼠等小型动物一样的效果时,Pereira马上制作了一个动态标记的长颈鹿视频。

Pereira解释说:“我们从Mpala研究站拍摄了一只长颈鹿的步行视频…并在30个视频帧中标记了追踪点,整个过程花了不到一个小时。LEAP随后能够在几秒钟内追踪整个视频的剩余部分(大约500帧)。”

在以前,开发可以追踪人体运动的AI工具依赖于大量手动标记数据的训练集,因为只有这样软件才可以稳健地支持具有截然不同背景或照明条件的不同数据。

Murthy对此则表示:“对于我们的情况而言,我们优化了类似的方法来处理实验室环境中采集的数据。我们建立了一个允许用户选择适合采集数据类型的神经网络的系统。”

上一篇:日本筑波大学提出全视差、景深的近眼AR显示器设计与渲染方法[ 07-16 ]

下一篇:没有了!