谷歌研究低成本内向外 6DoF VR控制器追踪系统

一系列的VR一体机将在2018年登陆市场,但至今都没有任何一款设备能够提供6自由度控制器输入。但这种情况或许很快就会发生改变。谷歌一份最新的研究详细介绍了一种低成本的内向外VR控制器追踪系统。

第一款提供内向外头部追踪功能的VR一体机即将面世:联想Mirage Solo(谷歌Daydream生态系统的一部分)和HTC Vive Focus。但这两款头显只配备了3自由度运动控制器,这意味着手部输入仅限于更抽象和更不具沉浸感的动作。

谷歌在研究论文中指出,许多VR一体机缺乏6自由度控制器追踪的原因是硬件成本,计算成本和遮挡问题。这篇题为《Egocentric 6-DOF Tracking of Small Handheld Objects》的说明了一种基于计算机视觉的6自由度控制器追踪方法,其可以在没有活动标记的情况下运行。

谷歌的论文作者Rohit Pandey,Pavel Pidlypenskyi,Shuoran Yang和Christine Kaeser-Chen写道:“我们的关键观察结果是,用户双手和双臂为控制器在影像中的位置提供了优秀的情景参考,即便控制器本身有可能被遮挡时也能提供十分稳定的线索。为了简化系统,我们选择了用于头显6自由度姿态追踪的相同摄像头来作为输入。在我们的实验中,它们是一对立体单色鱼眼摄像头。除了基于标准IMU的控制器之外,我们不需要额外的标记或硬件。”

论文作者表示,这种方法可以为基于IMU的控制器带来位置追踪。他们相信这有朝一日可以扩展到无控制器手部追踪。

像Santa Cruz这样的内向外控制器追踪方法使用摄像头寻找隐藏在控制器内部的IR LED标记,然后将标记的形状与已知形状进行比较以判断控制器的位置。谷歌的方法则是根据用户双手和双臂来推断控制器的位置。

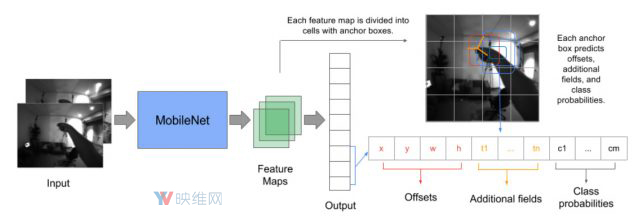

为了做到这一点,他们从头显角度捕获了大量的图像数据集。相关数据显示了用户以某种方式握持控制器的姿态。然后研究人员训练了一个神经网络(一个可以自我优化的程序)来检测图像,并且推断控制器的位置。通过数据集的学习,该算法可以根据从头显实时馈送的全新图像来推断控制器位置。另外,系统可以结合控制器的IMU数据来提高准确性。

在一个已被删除的视频中,我们看到了来自头显摄像头的视图,其中用户正在挥动一个看似Daydream控制器的设备。叠加在影像的内容是一个标记控制器位置的符号,其能够在用户移动手部时精确跟上控制器,即便控制器本身被用户手臂遮挡时也没有任何问题。

为了测试系统的准确性,研究人员使用了商业版外向内追踪系统来捕捉控制器的精确位置,然后再与他们的方法进行比较。结果表明,“3D关键点预测的平均误差为33.5毫米”(略大于1英寸)。研究人员表示,他们的系统能够以30FPS的速度在“单个移动CPU内核”运行,适用于移动VR硬件。

他们的方法仍然有提升的空间。论文作者指出,由于目前的模型是在逐帧基础上预测位置,而不是共享帧之间的信息,所以他们计划把帧之间的插值作为下一步方向,从而显著加快追踪速度。

谷歌计划公开用来训练算法的数据集,允许其他团队训练自己的神经网络以改善追踪系统。论文作者认为这是同类中规模最大的数据集,由大约547000对立体图像组成,而每幅图像中标记有控制器的精确6自由度位置。研究人员表示,20名用户在一系列的照明条件下进行了13种不同的运动,然后他们再将其编译成最终的数据集。

映维网预计谷歌有可能在5月8日-10日举行的I/O大会上公布更多的信息,以及数据集的公开时间。